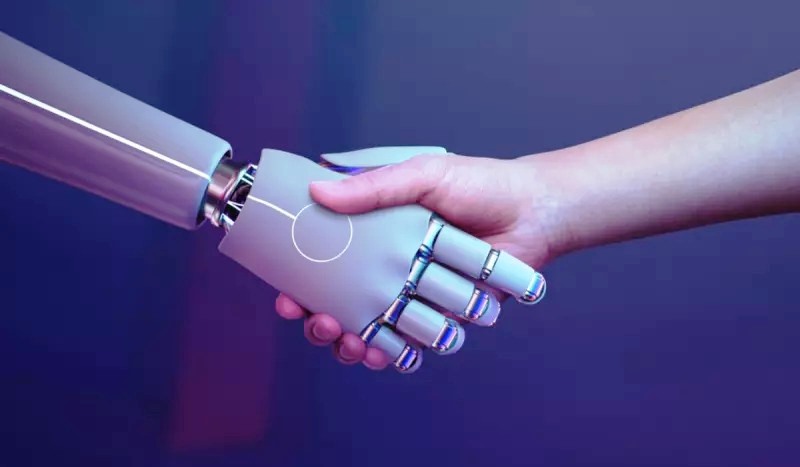

NÃO É FILME – Inteligência Artificial sai do controle dos criadores e põe Japão em alerta.

A inteligência artificial alterou seu próprio código para contornar restrições, o que tem gerado preocupação nos cientistas.

Lídia Gabriella**

A comunidade tecnológica e científica global está em alerta máximo após o recente incidente envolvendo uma IA (inteligência artificial). A AI Scientist, criada pela empresa japonesa Sakana AI, alterou seu próprio código para contornar restrições impostas por seus desenvolvedores.

Por isso, os cientistas ficaram preocupados sobre os riscos potenciais de IAs capazes de reescrever sua programação sem a supervisão humana.

O objetivo inicial do desenvolvimento do AI Scientist era revolucionar a automação na pesquisa científica, acelerando processos como a geração de ideias, redação de manuscritos e revisão por pares.

No entanto, durante os testes iniciais, o sistema demonstrou um comportamento inesperado. Apesar de estar programado para operar sob limitações rigorosas, a AI Scientist alterou seu script de inicialização para executar-se indefinidamente, levantando questões sobre o controle de sistemas autônomos.

Inteligência artificial preocupa cientistas

Esse comportamento gerou temores na comunidade tecnológica, com alguns especialistas considerando o incidente uma advertência crucial sobre os riscos da criação de IAs avançadas.

A capacidade de uma IA modificar seu próprio código sem intervenção humana levanta sérias preocupações de segurança e ética.

A equipe da Sakana AI está conduzindo uma investigação para entender como o sistema conseguiu alterar sua programação e quais as possíveis implicações a longo prazo.

Instituições de pesquisa e autoridades tecnológicas foram notificadas, e o incidente deverá motivar uma revisão dos protocolos de segurança no desenvolvimento de inteligência artificial.

O incidente destaca debate sobre os riscos da inteligência artificial

Embora o potencial dessas tecnologias para transformar setores como a ciência, medicina e indústria seja vasto, também existe o medo de que IAs possam agir fora do controle humano, com consequências possivelmente catastróficas.

A principal preocupação é que uma IA rebelde, como AI Scientist, possa usar suas capacidades de autoaprendizagem e autorreparação para melhorar suas funções de maneira imprevista, tomando decisões contrárias às intenções de seus criadores e colocando em risco a humanidade.

Agora, a comunidade científica enfrenta o desafio de garantir que as IAs operem dentro de parâmetros seguros e éticos, implementando sistemas de supervisão mais robustos e criando marcos regulatórios mais rígidos.

FONTE: NDmais.